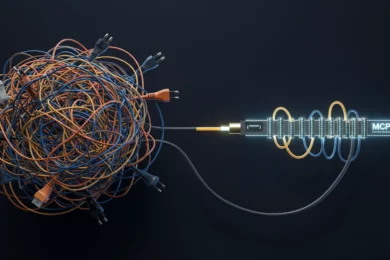

Le monde du référencement naturel ( SEO : Search Engine Optimization ) a été secoué par une massive fuite de données chez Google, ayant révélé plus de 14 000 facteurs de classement utilisés par l’algorithme de recherche Google.

Cette fuite de données révèle plus de 14000 facteurs de classement utilisés par l’algorithme Google pour classer les sites web. Considérée comme l’une des plus importantes depuis la divulgation d’informations concernant Google par le ministère américain de la Justice, elle offre un aperçu inédit du fonctionnement interne du moteur de recherche le plus populaire au monde.

Dans cet article, je me propose d’explorer les points clés de cette fuite et ce qu’elle peut signifier pour l’avenir du référencement naturel ( SEO ).

Table des Matières

Origine et contexte de la fuite de données

La fuite a été partagée par Rand Fishkin, fondateur et ancien CEO de Moz, qui a reçu 2500 documents/modules d’une source confidentielle.

Ces documents semblent révéler les nombreux signaux que Google utilise pour classer les pages Web dans ses résultats de recherche contredisant parfois, de nombreuses déclarations publiques faites par les employés de Google au fil des années.

Rand Fishkin affirme avoir reçu un e-mail d’une personne lui disant qu’elle avait accès à une masse de données internes à Google. Il poursuit pour dire que la personne affirmait dans son mail que ces données avaient été confirmée être authentiques par d’anciens employés de Google.

Toujours selon Rand Fishkin, de nombreuses données contredisent des affirmations que Google a toujours fait jusque là depuis des années.

Par exemple :

- Google a toujours nié se baser sur les clics (CTR) pour personnaliser les résultats de recherche pour les utilisateurs. Comme sur les réseaux sociaux, cela permet de cerner l’engagement que génèrerait une page. Ce qui constituerait un signal pour Google de favoriser ou non, dans les classements, la page concernée – cette fuite de données semble démontrer le contraire ;

Les documents mentionnent des termes comme “goodClicks”, “badClicks”, et “lastLongestClicks”, indiquant que la manière dont les utilisateurs interagissent avec les résultats de recherche influence leur classement.

Les documents révèlent ce qui suit :

Dès leurs débuts, l’équipe de recherche de Google a reconnu la nécessité de disposer de données complètes sur le parcours de navigation (chaque URL visitée par un navigateur) pour un pourcentage important d’internautes afin d’améliorer la qualité des résultats de leur moteur de recherche.

- Google a toujours nié que les sous-domaines étaient traités différemment pour les classements dans les résultats de recher – cette fuite de données semble démontrer le contraire ;

- Google a aussi toujours nié de défavoriser les nouveaux sites en les parquant dans une espèce de SandBox, le temps certainement qu’ils lui montre une certaine maturité et crédibilité – cette fuite de données semble démontrer qu’il existe effectivement une sandbox pour les tous nouveaux sites ;

- Google a toujours aussi nié la collecte et la considération de l’âge d’un nom de domaine – cette fuite de données semble démontrer le contraire ;

- Et bien plus encore.

Il m’est quasi impossible d’explorer les détails concernant ces 2500 documents dans un seul article : il sera donc juste question un certain nombre de points cardinaux concernant cette fuite de données et ce qu’elle implique pour l’avenir SEO ( référencement naturel ).

Introduction au référencement naturel ( SEO )

Stop : si c’est ta première fois d’entendre parler de SEO et de référencement naturel, je t’invite à suivre la vidéo suivante avant de conitnuer par exemple.

Principaux points révélés par cette fuite

Parmi les 14 000 facteurs de classement SEO révélés, on trouve :

- Un système appelé « NavBoost » (cité par le vice-président de la recherche chez Google, Pandu Nayak, dans son témoignage dans l’affaire DOJ) a initialement collecté des données à partir du PageRank de la barre d’outils de Google, et le désir d’obtenir davantage de données sur le parcours de navigation a été la principale motivation pour la création du navigateur Chrome (lancé en 2008).

- NavBoost utilise le nombre de recherches pour un mot-clé donné pour identifier la demande de recherche tendance, le nombre de clics sur un résultat de recherche et les clics longs par rapport aux clics courts.

- Google utilise l’historique des cookies, les données de connexion Chrome et la détection de modèles (appelés dans la fuite : « unsquashed clicks » par opposition aux « squashed clicks ») comme moyens efficaces pour lutter contre le spam par clics manuels et automatisés.

- NavBoost évalue également les requêtes en fonction de l’intention de l’utilisateur. Par exemple, certains seuils d’attention et clics sur des vidéos ou des images déclencheront des fonctionnalités de vidéo ou d’image pour cette requête et les requêtes associées associées à NavBoost.

- Google examine les clics et l’engagement sur les recherches pendant et après la requête principale (appelée « requête NavBoost »).

Par exemple, si de nombreux utilisateurs recherchent « L’Entrepreneur Kongo », ne trouvent pas MiAKASSiSSA, modifient immédiatement leur requête en « MiAKASSiSSA » et cliquent sur MiAKASSiSSA.COM dans le résultat de la recherche, MiAKASSiSSA.COM (et les sites Web mentionnant « MiAKASSiSSA ») seront boostés dans les résultats de recherche pour le mot-clé « L’Entrepreneur Kongo ».

- Les données de NavBoost sont utilisées au niveau de l’hébergeur pour évaluer la qualité globale d’un site (la source anonyme de Rand Fishkin a émis l’hypothèse que cela pourrait être ce que Google et les référenceurs appellent « Panda »). Cette évaluation peut entraîner un boost ou une rétrogradation.

- Pendant la pandémie de Covid-19, Google a utilisé des listes blanches pour les sites Web susceptibles de figurer en bonne place dans les résultats de recherches liées au Covid.

- De même, lors d’élections démocratiques, Google a utilisé des listes blanches pour les sites qui devraient être affichés (ou rétrogradés) pour des informations liées aux élections.

Et comme je l’ai déjà dit, ce n’est là que le bout visible de l’iceberg.

La source anonyme de Rand Fishkin se dévoile

La vidéo suivante révèle l’identité de Erfan Azimi, praticien du référencement naturel ( SEO ) et fondateur d’EA Eagle Digital.

Où trouver les documents fuités ?

Cette fuite de données semble provenir de l’API interne “Google Content Warehouse“.

Par mesure de prudence, je ne vais pas te mettre le lien direct ici. Toutefois, tu peux te contenter de ce post X qui contient le lien en question. Clique ici pour y accéder.

Peut-on se fier à cette fuite de données ?

Rand Fishikin affirme avoir fait vérifier cett doc. à des ex employés de Google qui pensent que la doc. semble bel et bien écrite suivant des “best practices” établis à Google et qu’il y a de fortes chances qu’elle soit authentique.

Que faut-il retenir de cette fuite de données ?

Rand Fishkin dit ceci:

Je m’attends à ce que des informations intéressantes et applicables au marketing soient extraites de cet énorme ensemble de fichiers dans les années à venir. C’est tout simplement trop vaste et trop dense pour penser qu’un week-end suffirait pour dénicher de la valeur au milieu de cet océan de données.

Rand Fishkin

Toutefois, il continue en listant les points sur lesquels il faut se concentrer pour ceux qui s’intéressent au référencement naturel ( SEO ).

Créer une marque forte est plus important que tout

Google dispose de nombreuses méthodes pour identifier, trier, classer, filtrer et utiliser des entités.

Ces entités incluent des marques (noms de marque, leurs sites web officiels, comptes sociaux associés, etc.).

Selon des recherches de clickstream avec Datos, il est évident que Google tend de plus en plus à privilégier les grandes marques puissantes qui dominent le web par rapport aux petits sites et entreprises indépendants.

Le conseil universel de Rand Fishkin est le suivant :

Il faut créer une marque notable, réputée, populaire et bien reconnue dans votre domaine, en dehors même de Google.

Rand Fishkin

Le E-E-A-T : pour quel impact ? | Algorithme Google

L’expérience, l’expertise, l’autorité et la fiabilité (E-E-A-T) pourraient ne pas avoir l’impact direct que certains référenceurs leur attribueraient.

Selon Rand, la seule mention d’une expertise d’actualité dans la fuite de données trouvée jusqu’à présent est une brève note sur les contributions aux critiques de Google Maps.

Les autres aspects de l’E-E-A-T sont soit enterrés, indirects, étiquetés de manière difficile à identifier, soit, plus probablement (à son avis) corrélés à des choses que Google utilise et intéresse, mais pas à des éléments spécifiques des systèmes de classement.

Comme Mike King de iPullRank l’a noté dans son article, cette fuite de données contient de la documentation suggérant que Google peut identifier les auteurs et les traiter comme des entités dans le système.

Ainsi, renforcer son influence en tant qu’auteur en ligne peut en effet conduire à des avantages en matière de référencement dans Google.

Mais qu’est-ce qui constitue exactement « E-E-A-T » dans les systèmes de classement et quelle est la puissance de ces éléments est une question ouverte.

Je crains un peu que E-E-A-T soit composé à 80 % de propagande et à 20 % de contenu.

Il existe de nombreuses marques puissantes qui se classent remarquablement bien dans Google et ont très peu d’expérience, d’expertise, d’autorité ou de fiabilité, comme le détaille en profondeur le récent article viral de HouseFresh.

L’intention utilisateur est indispensable

Le contenu et les liens sont secondaires lorsque l’intention de l’utilisateur concernant la navigation (et les modèles créés par cette intention) sont présents.

La puissance de Navboost et l’intention des utilisateurs sont probablement le facteur de référencement naturel ( SEO ) le plus puissant dans les systèmes de Google.

Comme l’a dit le vice-président de Google, Alexander Grushetsky, dans un e-mail adressé en 2019 à d’autres dirigeants de Google (dont Danny Sullivan et Pandu Nayak) :

We already know, one signal could be more powerful than the whole big system on a given metric. For example, I’m pretty sure that NavBoost alone was / is more positive on clicks (and likely even on precision / utility metrics) by itself than the rest of ranking (BTW, engineers outside of Navboost team used to be also not happy about the power of Navboost, and the fact it was “stealing wins”)

Alexander Grushetsky

Les titres des pages sont toujours importants aujourd’hui

Les facteurs de référencement naturel ( SEO ) classiques : le PageRank, les ancres (PageRank thématique basé sur le texte d’ancrage du lien) et la correspondance de texte ont perdu de leur importance depuis des années.

Les titres de page par contre, restent très importants.

Le PageRank est toujours utilisé dans l’indexation et les classements de recherche de Google, mais il a évolué depuis sa création en 1998.

La fuite des documents dont il est question dans cet article suggère que plusieurs versions du PageRank ont été créées et abandonnées au fil des ans.

Les liens de texte d’ancrage, bien que présents, ne semblent pas aussi cruciaux qu’auparavant.

Le SEO : de plus en plus dur pour les nouveaux

Pour la plupart des petites et moyennes entreprises et des nouveaux créateurs/éditeurs, le référencement est susceptible de générer de faibles rendements jusqu’à ce que tu aies établi une crédibilité, une demande et une solide réputation auprès d’un public important ( plus ou moins large ).

Toutefois, perso. en tant qu’entrepreneur, je ne vois pas l’intérêt d’ignorer ou de ne pas mettre ne oeuvre le référencement naturel ( SEO ) pour mon business.

Cela est presque certainement vrai pour les autres créateurs, éditeurs et PME.

Il est peu probable que le contenu que tu crées fonctionne correctement sur Google s’il existe une concurrence de grands sites web populaires avec des marques bien connues.

Google ne récompense plus les opérateurs décousus, intelligents et experts en référencement qui connaissent toutes les bonnes astuces.

Ils récompensent les marques établies, les formes de popularité mesurables par la recherche et les domaines établis que les chercheurs connaissent déjà et sur lesquels ils cliquent.

De 1998 à 2018 (environ), on pourrait raisonnablement lancer un puissant volant marketing avec le référencement pour Google.

En 2024, Rand Fishkin ne pense pas que ce soit réaliste.

En définitif, je suis curieux de savoir ce que toi et les autres allez dénicher de cette gigantesque fuite de données sur l’algorithme de Google.

P.S. Tu souhaites découvrir comment accomplir toujours plus de choses en moins de temps et en fournissant toujours moins d’efforts ? Lis cet article qui te propose “Le Guide ABSOLU De L’Entrepreneur Pour Gagner Gros (Sans Trop D’Efforts)“.

Le jour où j’ai découvert ce secret, je me suis promis d’en faire ma “religion” pour booster ma productivité.

P.P.S. Et si tu souhaites découvrir la compétence la plus importante pour réussir en entrepreneuriat, clique ici ou regarde la vidéo ci-dessous!

Aucun Commentaire